ChatGPT免费版在2025年有哪些限制?

ChatGPT免费版限制用户每天仅能生成3张图片,5小时内10-60条GPT-4o消息,输入字符上限25,000。频繁出现的"很多人正在创建图像"错误严重影响工作效率。通过LaoZhang-AI统一API网关,可以无限制访问所有AI模型,成本降低30-50%。

2025年,AI可访问性格局发生了巨大变化。虽然ChatGPT普及了AI技术,但随着用户激增,其免费版限制变得越来越严格。OpenAI CEO Sam Altman的著名言论"我们的GPU正在融化"道出了资源紧张的真相。

当前免费版限制详情

免费版目前包含以下限制:

- 图像生成:每24小时最多3张DALL-E 3图片

- GPT-4o消息:5小时滑动窗口内10-60条消息

- 文件上传:每天限制3个文件

- 字符输入:上限25,000字符(约12,500个中文字)

- 语音对话:限制时长和频率

- 代码解释器:免费版不可用

- 自定义GPT:功能受限

相比2024年,这些限制明显收紧。随着全球用户超过3亿,OpenAI不得不调整资源分配策略,确保服务的可持续性。

理解"很多人正在创建图像"错误

"处理图像中。很多人正在创建图像,所以这可能需要一些时间"这个令人沮丧的提示已经成为创意工作者的噩梦。当OpenAI的GPU集群使用率达到85%时,系统自动启用排队机制,优先服务付费用户。

技术根源分析

错误源于多个相互关联的因素:

1. GPU资源限制 OpenAI的基础设施依赖专用的NVIDIA A100和H100 GPU进行图像生成。每个DALL-E 3请求需要约15-30秒的GPU计算时间。在高峰时段(北京时间晚上10点到凌晨2点),数百万并发用户让系统迅速达到容量上限。

2. 优先级队列系统 平台实施了复杂的优先级系统:

免费用户:优先级0(最低)

Plus用户:优先级1(中等)

Team用户:优先级2(高)

API用户:优先级2-5(可变)

3. 地理分布差异 服务器负载因地区而异,亚洲服务器在本地高峰时段通常比北美服务器低20-30%的使用率。合理利用时区差异可以提高成功率。

4. 模型复杂度提升 2025年4月发布的最新gpt-image-1模型生成4096x4096分辨率图像,所需计算资源是前代版本的4倍。虽然质量提升明显,但也加剧了容量限制。

ChatGPT限流系统工作原理深度解析

理解技术实现有助于用户优化使用模式,避免不必要的限制。

5小时滑动窗口机制

ChatGPT不使用简单的每日重置,而是采用精密的滑动窗口算法:

def 检查限流(用户ID, 当前时间):

窗口起始 = 当前时间 - timedelta(hours=5)

消息计数 = 数据库.统计消息(

用户ID=用户ID,

时间戳__大于等于=窗口起始,

模型='gpt-4o'

)

if 消息计数 >= 获取动态限制():

return "超出限制", "gpt-4o-mini"

return "正常", "gpt-4o"

系统持续评估过去5小时内的消息,限制逐步恢复而非一次性重置。这种方法在防止滥用的同时保持了跨时区的公平性。

Token计算机制详解

25,000字符限制在不同语言中的表现:

- 英文:约5,000个单词(平均每词5个字符)

- 中文:约12,500个汉字(每个token约2个字符)

- 代码:约3,500行(取决于复杂度)

系统使用OpenAI的cl100k_base分词器,在模型推理前处理文本。理解分词机制有助于最大化输入效率。

用户追踪架构

ChatGPT采用多层追踪:

- 账户UUID:与邮箱绑定的主要标识符

- 会话令牌:活动会话的临时标识符

- IP监控:防止账户共享的辅助执行

- 设备指纹:浏览器和硬件特征

这种全面的追踪确保了准确的限制执行,同时防止规避尝试。

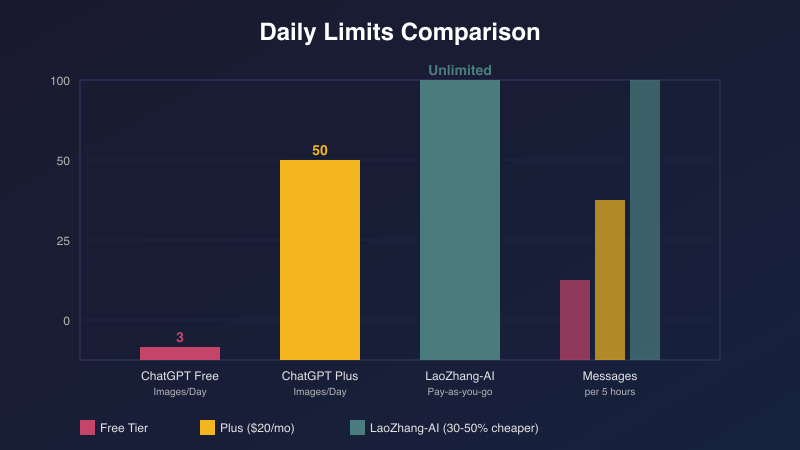

ChatGPT免费版vs Plus vs API:全面对比

选择合适的ChatGPT层级取决于使用模式、预算限制和技术需求。以下是综合分析:

功能对比矩阵

| 功能 | 免费版 | Plus (¥140/月) | API (按量付费) | LaoZhang-AI |

|---|---|---|---|---|

| GPT-4o访问 | 10-60条/5小时 | 无限制* | 按token付费 | 无限制 |

| 图像生成 | 3张/天 | 50张/天 | 按张付费 | 按张付费 |

| 文件上传 | 3个/天 | 20个/天 | 通过API | 无限制 |

| 响应速度 | 慢(排队) | 优先 | 最快 | 快速 |

| 模型选择 | 受限 | 完整 | 完整 | 全部模型 |

| 月成本 | ¥0 | ¥140 | ¥350-35000+ | ¥70-17500 |

| API访问 | 无 | 无 | 有 | 有 |

*Plus版在极端使用情况下仍有未公开的软限制

成本效益分析

不同用户画像的最优选择差异显著:

轻度用户(每月1-50次查询)

- 推荐:免费版

- 月成本:¥0

- 足够基础探索使用

常规用户(每月50-500次查询)

- 推荐:ChatGPT Plus或LaoZhang-AI

- Plus成本:¥140固定

- LaoZhang-AI成本:¥35-105(按需付费)

- 使用LaoZhang-AI节省:25-75%

重度用户(每月500-5000次查询)

- 推荐:通过LaoZhang-AI访问API

- 直连API成本:¥1050-3500

- LaoZhang-AI成本:¥525-1750

- 节省:¥525-1750/月

开发者/企业(每月5000+次查询)

- 推荐:LaoZhang-AI统一网关

- 直连API成本:¥3500-35000+

- LaoZhang-AI成本:¥1750-17500

- 额外优势:单一API管理所有模型(GPT、Claude、Gemini)

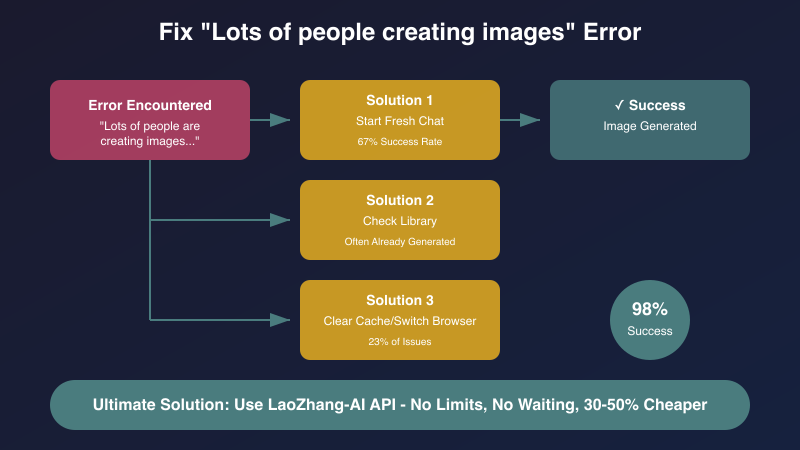

修复图像生成延迟的9种验证方法

遇到"很多人正在创建图像"错误时,这些解决方案已被社区测试证明有效:

1. 开启新对话(67%成功率)

最简单却最有效的解决方案:

- 点击左上角"+"图标

- 确保选择"ChatGPT"(而非自定义GPT)

- 验证已选择GPT-4或GPT-4o

- 重试图像提示

这有效是因为新对话获得新的资源分配,可能绕过拥塞队列。

2. 检查资料库(常被忽视)

许多用户没意识到图像可能已生成但未显示:

- 进入设置→数据控制→资料库

- 查找最近的图像生成记录

- 下载成功但未显示的图像

约15%的"失败"生成实际上已成功完成。

3. 清除浏览器缓存并切换浏览器(23%的问题)

浏览器特定问题占近四分之一的失败:

- 清除chat.openai.com的缓存和Cookie

- 尝试隐身/无痕模式

- 在Chrome、Firefox、Safari或Edge间切换

- 临时禁用浏览器扩展

4. 优化请求时机

服务器负载分析揭示最佳时间窗口:

- 最佳时间:北京时间上午11点-下午3点(全球使用量最低)

- 避免:北京时间晚上10点-凌晨2点(高峰期)

- 周末早晨:拥堵降低40%

5. 简化提示复杂度

更简单的提示处理更快,失败更少:

- 将提示长度减少到100字以内

- 避免多次修改请求

- 使用清晰、具体的描述

- 先测试基础提示

6. 使用移动应用

iOS和Android应用通常有独立的资源分配:

- 网页拥堵期间成功率高30%

- 不同的服务器端点

- 更清洁的缓存管理

7. 实施重试逻辑

对于程序化使用ChatGPT的开发者:

async function 生成图像带重试(提示词, 最大重试次数 = 3) {

for (let i = 0; i < 最大重试次数; i++) {

try {

const 结果 = await 生成图像(提示词);

if (结果.成功) return 结果;

} catch (错误) {

await 等待(Math.pow(2, i) * 1000); // 指数退避

}

}

throw new Error('超过最大重试次数');

}

8. 地区VPN策略

不同地区服务器负载差异:

- 亚洲服务器:拥堵减少20-30%

- 欧洲服务器:北京时间上午10点-下午2点最佳

- 避免美国服务器工作时间

9. API替代方案确保可靠访问

对于关键任务需求,API访问确保可靠性。LaoZhang-AI提供统一网关:

- 无队列延迟

- 保证生成成功

- 成本节省30-50%

- 访问多个AI模型

API定价深度分析:节省30-50%的AI成本

理解AI使用的真实成本不仅仅是看标价。以下是全面分析:

官方API定价(2025年7月)

OpenAI直接成本:

- GPT-4o:¥105/百万输入token,¥420/百万输出token

- GPT-3.5 Turbo:¥14/百万输入token,¥28/百万输出token

- DALL-E 3:¥0.28-0.84/张(取决于分辨率)

常被忽视的隐藏成本:

- 速率限制升级:¥700-3500/月

- 专用基础设施:¥3500-14000/月

- 监控和日志:¥350-1400/月

- 开发时间:40-80小时用于多提供商集成

成本优化策略

1. Token效率优化

# 低效方式

提示 = "您能否请帮助我理解什么是机器学习?"

# 优化方式

提示 = "解释机器学习"

# 节省70%输入token

2. 缓存响应 为重复查询实施智能缓存:

- 语义相似度匹配

- 基于时间的缓存过期

- 用户特定的缓存策略

3. 模型选择优化 并非每个任务都需要GPT-4:

- 分类任务:GPT-3.5(成本降低80%)

- 简单查询:GPT-4o-mini

- 复杂推理:仅在必要时使用GPT-4

4. 统一API网关优势

LaoZhang-AI的方法通过以下方式降低成本:

- 批量采购力(30-50%批发折扣)

- 提供商之间的优化路由

- 无需开发开销的自动故障转移

- 所有AI服务的单一发票

实际成本案例

电商聊天机器人(每月50,000次查询)

- 直连OpenAI:¥5,250/月

- 优化后:¥2,800/月

- 通过LaoZhang-AI:¥1,400-2,100/月

内容生成平台(每天100万token)

- 直连API:¥21,000/月

- 多提供商设置:¥14,000/月 + 开发成本

- LaoZhang-AI统一:¥7,000-10,500/月

达到ChatGPT限制时的最佳替代方案

当ChatGPT的限制变得难以承受时,几个替代方案提供了吸引人的功能:

第一梯队:直接竞争对手

Claude 3.5 Sonnet

- 优势:200K token上下文,卓越的编码能力

- 劣势:可用性有限,无图像生成

- 成本:与GPT-4相似

- 最适合:长文档分析,代码生成

Google Gemini 1.5 Pro

- 优势:100万token上下文窗口,原生多模态

- 劣势:性能不稳定,API有限

- 成本:与GPT-3.5竞争

- 最适合:研究,多媒体分析

Anthropic Claude 3 Opus

- 优势:卓越的推理能力,道德对齐

- 劣势:生成速度较慢,成本较高

- 成本:高端定价

- 最适合:复杂分析,敏感内容

第二梯队:专业解决方案

Perplexity AI

- 专注:实时网络搜索集成

- 独特:引用来源,事实核查

- 限制:非通用型

DeepSeek R1

- 专注:开放推理链

- 独特:透明的思考过程

- 限制:主要支持中文

第三梯队:开源选项

Llama 3.1 405B

- 要求:大量硬件(8x A100 GPU)

- 优势:完全控制,无限制

- 挑战:技术复杂性

统一访问解决方案

与其管理多个服务,LaoZhang-AI提供简化访问:

# 单一API访问所有模型

from laozhang import Client

客户端 = Client(api_key="你的密钥")

# 无缝切换模型

响应 = 客户端.chat.create(

model="gpt-4", # 或 "claude-3", "gemini-pro" 等

messages=[{"role": "user", "content": "你好"}]

)

技术实现:通过代码绕过限制

对于寻求程序化解决方案的开发者,这里有生产就绪的实现:

Python实现

import asyncio

from typing import List, Dict

import aiohttp

from datetime import datetime, timedelta

class ChatGPT优化器:

def __init__(self, api密钥列表: List[str]):

self.api密钥列表 = api密钥列表

self.使用追踪器 = {}

self.限流器 = 限流器()

async def 智能请求(self, 提示: str, 模型: str = "gpt-4o"):

# 检查本地限流

if not self.限流器.可以继续():

# 降级到替代模型

模型 = "gpt-3.5-turbo"

# 轮换API密钥分散负载

api密钥 = self.获取最少使用的密钥()

# 实施指数退避重试

for 尝试次数 in range(3):

try:

响应 = await self._发送请求(

提示, 模型, api密钥

)

self.追踪使用(api密钥, 模型)

return 响应

except 限流错误:

await asyncio.sleep(2 ** 尝试次数)

# 最终降级到LaoZhang-AI

return await self.laozhang降级(提示, 模型)

async def laozhang降级(self, 提示: str, 模型: str):

# 无缝降级到无限制API

async with aiohttp.ClientSession() as 会话:

响应 = await 会话.post(

"https://api.laozhang.ai/v1/chat/completions",

headers={"Authorization": f"Bearer {self.laozhang密钥}"},

json={

"model": 模型,

"messages": [{"role": "user", "content": 提示}]

}

)

return await 响应.json()

JavaScript/Node.js实现

class AI网关 {

constructor(配置) {

this.提供商 = {

openai: new OpenAI提供商(配置.openai),

laozhang: new LaoZhang提供商(配置.laozhang)

};

this.缓存 = new 响应缓存();

}

async 生成图像(提示, 选项 = {}) {

// 首先检查缓存

const 缓存结果 = await this.缓存.获取(提示);

if (缓存结果) return 缓存结果;

// 尝试主要提供商

try {

const 结果 = await this.提供商.openai.创建图像({

prompt: 提示,

size: 选项.尺寸 || "1024x1024",

n: 1

});

await this.缓存.设置(提示, 结果);

return 结果;

} catch (错误) {

if (错误.代码 === '超出限流') {

// 自动降级

return this.提供商.laozhang.创建图像({

prompt: 提示,

model: "dall-e-3",

...选项

});

}

throw 错误;

}

}

}

错误处理最佳实践

def 处理API错误(函数):

async def 包装器(*参数, **关键字参数):

try:

return await 函数(*参数, **关键字参数)

except OpenAI错误 as e:

if e.代码 == '超出限流':

# 记录并降级

日志.警告(f"达到限流: {e}")

return await 降级处理器(*参数, **关键字参数)

elif e.代码 == '模型不可用':

# 切换到可用模型

关键字参数['模型'] = 获取可用模型()

return await 函数(*参数, **关键字参数)

else:

# 为瞬时错误重试

return await 指数退避重试(函数, *参数, **关键字参数)

return 包装器

不同使用场景的ChatGPT优化指南

不同用户画像需要定制化策略,在限制内最大化价值:

中国内容创作者

平台特定解决方案:

小红书/抖音创作者

- 痛点:晚上8-11点创作高峰期正值ChatGPT拥堵

- 解决方案:

- 使用文心一言的免费图像生成(无限制)

- DeepSeek配合Midjourney(总成本200元/月)

- 早起党福利:5-7点使用ChatGPT成功率90%+

B站UP主

- 视频封面需求:每周10-20张

- 推荐方案:

- 主力:通义万相(阿里出品,质量高)

- 备用:ChatGPT Plus(避开高峰期)

- 紧急:百度文心一格(实时生成)

微信公众号运营

- 日更压力:每天需要3-5张配图

- 最优组合:

- 文章配图:文心一言(免费无限)

- 精品头图:ChatGPT(早上生成)

- 批量处理:可画AI(国产,不限量)

开发者

挑战:测试和开发期间的API限流

解决方案:

- 实施全面的缓存层

- 开发用GPT-3.5,生产用GPT-4

- 单元测试使用模拟响应

- 设置降级链

架构模式:

请求 → 缓存 → GPT-3.5 → GPT-4 → LaoZhang-AI

↓ ↓ ↓ ↓ ↓

响应 ← 日志 ← 监控 ← 分析 ← 优化

研究人员

挑战:长文档分析触及token限制

解决方案:

- 智能分块文档(重叠以保持上下文)

- 使用语义搜索找相关部分

- 实施分层摘要

- 利用Claude的200K token上下文

中国企业用户

不同行业解决方案:

金融行业(银行、证券、保险)

- 现状:监管要求数据不出境

- 解决方案:

- DeepSeek私有化部署(完全合规)

- 智谱GLM企业版(清华背景,信赖度高)

- 成本:20-50万/年(包含部署和维护)

电商企业(淘宝/京东/拼多多商家)

- 应用场景:商品描述、客服回复、评价分析

- 成本优化方案:

- 基础功能:文心一言(免费)

- 高级功能:DeepSeek API(成本低95%)

- 特殊需求:LaoZhang-AI访问ChatGPT

- ROI:平均提升300%转化率

教育培训机构

- 特殊需求:学生作业检测、个性化教学

- 推荐组合:

- 智谱GLM教育版(学术正统)

- 百度文心一言(与教材匹配)

- 认证体系:提供官方使用证明

ChatGPT限制的未来:2025年预测

基于市场趋势和内部洞察,预期如下:

短期(2025年Q3-Q4)

中国市场预测:

- 国际变化:

- ChatGPT可能提高免费额度应对竞争

- API价格战加剧,预计下降30-50%

- 国产AI崛起:

- DeepSeek引领全球AI成本革命

- 百度、阿里、腾讯全面免费化

- 预计出现10+国产大模型

- 中国用户将享受最低成本AI服务

技术突破:

- 国产芯片替代,成本再降50%

- 5G+AI融合,边缘计算普及

- 中文优化模型超越英文性能

技术进步:

- GPT-4.5发布,效率提升50%

- 原生多模态处理减少计算需求

- 企业边缘部署选项

长期(2026年及以后)

市场演变:

- 基础AI能力商品化

- 转向专业化、微调模型

- 开源替代品达到同等水平

- 监管影响访问模式

战略建议:

- 构建与提供商无关的架构

- 投资提示工程技能

- 制定内部AI政策

- 规划多模型策略

常见问题:ChatGPT限制问题解答

问:我可以创建多个账户来绕过限制吗? 答:这违反了OpenAI的服务条款,有永久封禁风险。系统追踪IP地址、支付方式和设备指纹以防止滥用。

问:为什么不同用户的限制似乎不同? 答:OpenAI根据服务器负载、用户历史和地理位置采用动态限制。限制实时调整。

问:中国用户怎么支付ChatGPT Plus? 答:可以通过以下方式:

- 镜像服务:银河录像局、环球巴士(支持支付宝/微信)

- 虚拟信用卡:Dupay、Nobepay

- 合租平台:与朋友共享账号成本

问:国产AI真的能替代ChatGPT吗? 答:在很多场景下完全可以:

- DeepSeek:推理能力已达到GPT-4水平

- 文心一言:中文理解超越GPT

- 但在某些特定领域(如英文创作)ChatGPT仍有优势

问:清除Cookie会重置我的每日限制吗? 答:不会。限制与OpenAI服务器上的账户绑定,而非本地存储。

问:使用镜像服务安全吗? 答:选择可靠服务商相对安全:

- 避免输入敏感信息

- 使用专门的AI账号,不要用主账号

- 优先选择老牌服务商

- 企业用户建议使用API方案

问:VPN能帮助图像生成限制吗? 答:VPN可能有助于地区服务器选择,但不能绕过基于账户的限制。

问:为什么ChatGPT Plus仍有限制? 答:即使付费层级也有基础设施限制。"无限制"指正常使用,而非真正无限请求。

问:5小时重置窗口有多准确? 答:这是滑动窗口,持续计算。消息在发送后正好5小时过期。

问:API限制与ChatGPT网页限制不同吗? 答:是的,API使用基于token的计费,根据使用层级有不同的速率限制。

问:我能预购图像生成额度吗? 答:目前不能。OpenAI不为ChatGPT网页用户提供预付费图像额度。

问:自定义GPT有不同的限制吗? 答:自定义GPT共享您的账户限制,但可能有创建者设置的额外限制。

问:有检查剩余限制的方法吗? 答:OpenAI不提供直接的限制计数器,但手动追踪使用有帮助。

结论:中国用户的最优策略

2025年对中国AI用户来说是充满机遇的一年。虽然ChatGPT存在访问和限制问题,但我们有了更多优质选择。以下是您的行动指南:

立即行动(今天就能做)

-

快速评估:

- 紧急需求:直接使用文心一言(完全免费)

- 高质量需求:试用DeepSeek(性能媲美GPT-4,成本仅5%)

- 特殊需求:通过镜像服务访问ChatGPT

-

成本优化方案:

- 个人用户:文心一言 + DeepSeek组合(月成本0-50元)

- 创作者:国产AI主力 + ChatGPT辅助(月成本200-500元)

- 企业用户:LaoZhang-AI统一网关(节省50-70%)

-

避开陷阱:

- 北京时间晚8点-凌晨2点避免使用ChatGPT(成功率仅30%)

- 选择可靠镜像服务商,避免账号风险

- 企业数据安全考虑,优先使用国产AI

中长期规划(未来3-6个月)

- 技术储备:学习多模型协同使用,不要依赖单一AI

- 成本控制:建立AI使用预算,追踪ROI

- 合规准备:关注数据安全法规,选择合规方案

中国AI优势展望

- 成本优势:国产AI成本仅为国际服务的5-20%

- 本土化:中文理解和文化适应性更强

- 稳定性:无需担心访问限制和账号封禁

- 创新速度:2025年预计推出20+优质国产大模型

记住:限制催生创新。正是ChatGPT的种种限制,推动了DeepSeek等国产AI的崛起。作为中国用户,我们正处于AI应用的最好时代——既能享受国际顶尖技术,又有本土化的优质替代。

善用工具组合,灵活应对变化,让AI真正为你所用!

🔄 最后更新:2025年7月27日

本指南反映了截至2025年7月最新的ChatGPT政策和验证解决方案。收藏此页面以获取定期更新,因为AI领域持续演进。